AI项目适用的#开源数据框架

Resource Collection · Linux DO

Published: 2025-06-23

Source: linux.do

AI_data_hubOpen Source Project

AI项目适用的数据中心,整合流行有用的数据库和AI数据功能,方便AI数据项目的开发,开箱即用,节省时间。

Ingestion

数据摄取

Transform

数据加工

Explore

探索分析

Retrieve

查询检索

整合组件: mongo_db, postgres_db /Supabase, mysql, Chroma/Milvus, langchain, langragh, 图片多模态/图片搜索, ALIYUN_OSS, RAG和基础agent, 爬虫功能, FastAPI

安装指南Installation

1. 配置环境

把data.env-dev 改为 .dev, 配置好参数秘钥

AI Service APIs: OPENAI_API_KEY, OPENAI_MODEL, TAVILY_API_KEY

Database Connections: MONGO_URI, POSTGRES_USERNAME, POSTGRES_PASSWORD

Cloud Storage: ALIYUN_OSS_ACCESS_KEY_ID, ALIYUN_OSS_BUCKET_NAME

Web Scraping: XHS_AUTH_TOKEN, GZH_AUTH_TOKEN, SCRAPING_INTERVAL

2. 安装数据库环境

Python conda环境 & docker环境

# Python conda环境

https://zhuanlan.zhihu.com/p/22678445 , 选择Python 3.10

conda active env_310

# docker环境

# 安装Postgres

docker run --name my-postgres -e POSTGRES_USER=myuser -e POSTGRES_PASSWORD=mypassword -e POSTGRES_DB=mydatabase -p 5432:5432 -d postgres

# 安装Mongo

docker run -d --name mongodb -p 27017:27017 mongo

# 安装Chroma

conda install chromadb

docker run -d --name chroma -p 8000:8000 -v chroma-data:/data chromadb/chroma

3. 安装依赖

pip install -r requirements.txt

4. 启动服务

python rest_api/main.py

# 测试服务

(env_310) D:\AI_data_hub>python -m rag_graphs.gzh_rag_graph.ingestion #测试rag

(env_310) D:\AI_data_hub>python -m scraper.xhs_scraper #测试爬虫

5. 访问

http://localhost:8000

01 Ingestion数据摄取

外部 API 集成

-

OpenAI 集成: 通过 OPENAI_BASE_URL https://openai.api2d.net/v1 使用 gpt-4.1-mini 模型

-

Tavily Search: 通过 TAVILY_API_KEY 提供搜索功能

-

LangSmith Tracing: 使用 ENABLE_LANGSMITH 配置的可选监控

网页抓取和数据收集

-

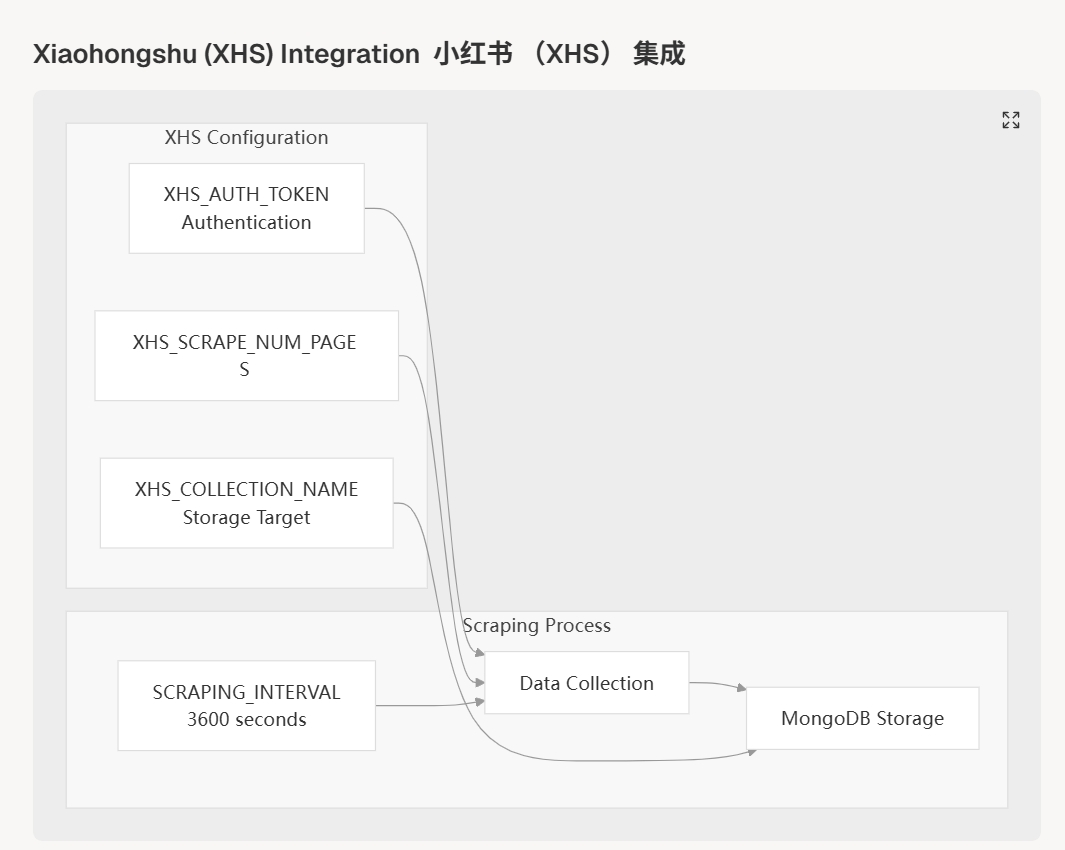

小红书 (XHS)

取用tikhub.io第三方数据服务,通过 XHS_AUTH_TOKEN 进行身份验证,可配置的页面限制,采集小红书相关丰富的数据

-

GZH 平台

取用tikhub.io第三方数据服务,通过 GZH_AUTH_TOKEN、可配置的页面限制进行身份验证,采集GZH平台相关丰富的数据

-

其他各大社交媒体和重要数据可以通过tikhub.io第三方数据服务进行采集

采集的渠道小红书数据流程:

02 Transform数据加工

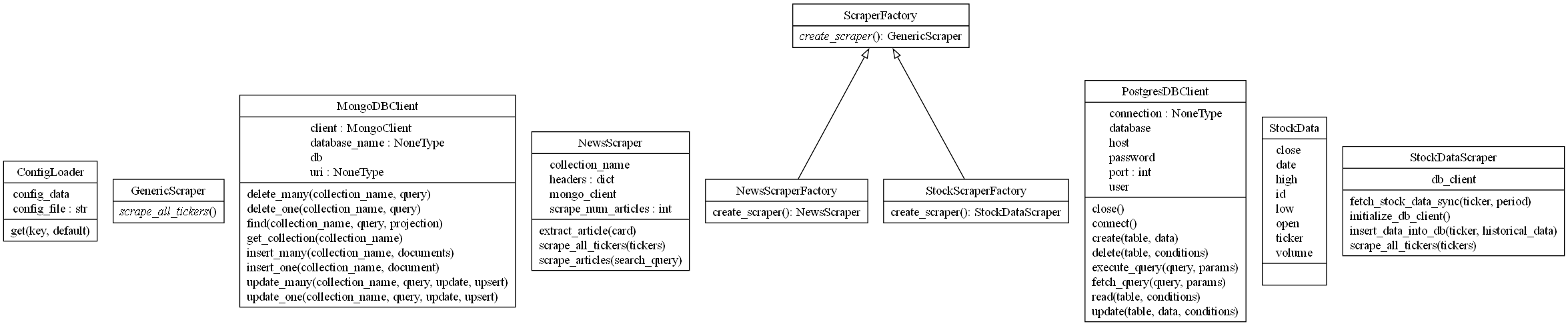

采集的各渠道数据,从非结构化到结构化,进行数据清洗和转换,以确保数据的准确性和一致性。

例如:

python -m rag_graphs.gzh_rag_graph.ingestion 把文章内容通过向量数据库保存,进一步提供给AI使用RAG功能。

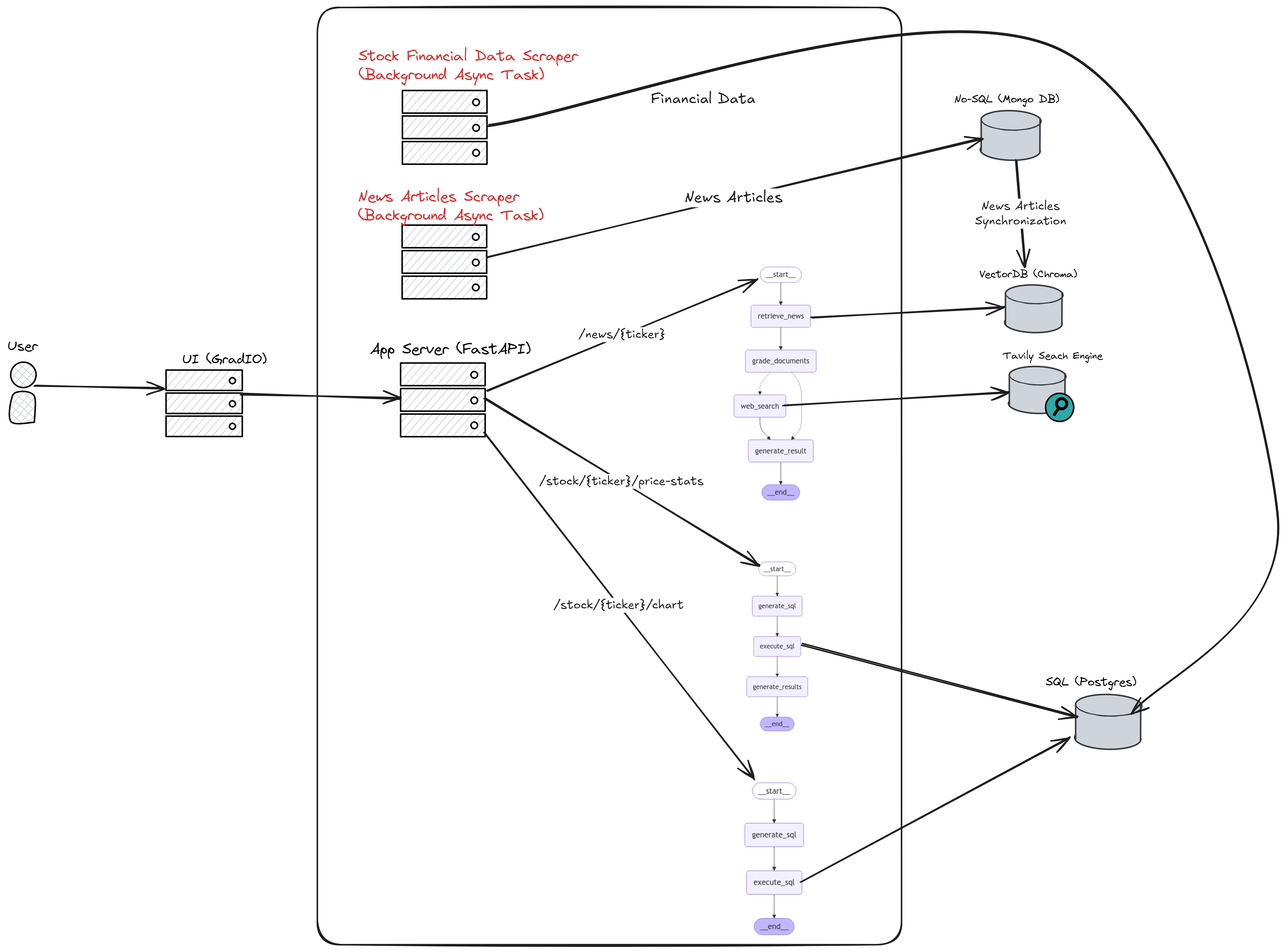

High Level Design:

03 Explore探索分析

MongoDB

灵活数据存储的主要文档数据库,包括json结构嵌入和抓取内容。

PostgreSQL

使用定义的架构处理结构化股票市场数据,以实现高效的查询和分析。

向量数据库

使用基于目录的存储来嵌入向量和相关元数据,并通过 VECTOR_DB_DIRECTORY 配置进行管理。

阿里云OSS

为报告、处理的数据和备份存储提供基于云的文件存储。

04 Retrieve查询检索

NL2SQL

自然语言查询,并将其转换为针对 PostgreSQL 数据库的可执行 SQL 查询。该系统代表了一个简化的两阶段工作流,专门关注 SQL 的生成和执行,无需额外的结果格式化。

Rest_api

fastapi服务对外提供数据接口访问。

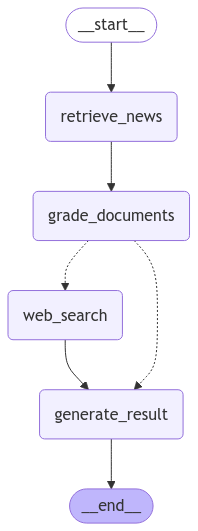

Langraph RAG

Graph System 使用 LangGraph 的 StateGraph 框架实现了简化的 RAG 工作流程。系统使用 LangGraph 的 StateGraph 框架来编排多步骤工作流,以维护处理节点之间的状态。

多模态相关图片查询检索

图片多模态处理和上传到向量数据库,图片以文搜图,图搜图功能在rest_api/app.py中,实现了图片多模态处理和上传到向量数据库,图片以文搜图,图搜图功能。

使用方法Usage

设置数据处理定时任务

在 rest_api/main.py 中:

scrape_in_interval(interval: int)

run_scrapers_in_background()

可以自行设置定时任务,

开始使用 AI_data_hub

开源项目 · 开箱即用 · 节省时间